Umělá inteligence je plná módních slov. Tím největším je momentálně "Velký jazykový model" neboli LLM. Znáte je jako mozky, které pohánějí ChatGPT, Claude a Gemini. Píší básně, ladí kód a odpovídají na složité otázky, které tradiční software matou.

Ale jak? Je to magie? Je to vědomí?

Ne. Je to matematika. Spousta matematiky. Konkrétně lineární algebra a počty v měřítku, které je pro lidský mozek těžko pochopitelné. Ale nebojte se. K pochopení mechaniky nepotřebujete doktorát.

Abychom skutečně pochopili, proč jsou tyto modely tak mocné, musíme se podívat pod kapotu. Musíme prozkoumat digitální neurony, které je pohánějí. Rozebereme motor, který mění globální ekonomiku. Jeden token po druhém.

Obsah

Co je to Velký jazykový model?

Velký jazykový model (LLM) je pravděpodobnostní model AI trénovaný na masivních datových sadách k rozpoznávání, predikci a generování textu. Na rozdíl od tradičního softwaru, který se řídí pevnými pravidly, LLM pracuje s pravděpodobnostmi.

Abyste pochopili "pravděpodobnostní", představte si, že se zeptáte tradičního počítačového programu, kolik je 2 + 2. Zkontroluje pevně zakódované pravidlo ve svém procesoru a vrátí "4". Je deterministický. Vrátí "4" pokaždé, navždy.

Když se zeptáte LLM, nepočítá matematiku v tradičním smyslu. Podívá se na miliardy případů, kdy se v jeho tréninkových datech (od učebnic matematiky po vlákna na Redditu) objevilo "2 + 2 =", a předpoví, že "4" je statisticky nejpravděpodobnější další znak. Upřednostňuje statistickou pravděpodobnost sekvencí před rigidní logikou. Nezná fakta jako absolutní pravdy. Mapuje pravděpodobnost vztahů mezi tokeny ve vícerozměrném vektorovém prostoru. Předpovídá pokračování vzoru, místo aby přistupoval k databázi faktů.

Evoluce AI textu: Od n-gramů k Transformerům

Abychom ocenili moderní LLM, musíme se podívat na jejich předchůdce. Historie NLP (zpracování přirozeného jazyka) je historií snahy dát počítačům "paměť".

Doba kamenná: N-gramy. Tyto rané modely byly neuvěřitelně jednoduché. Dívaly se pouze na bezprostředně předcházející slova. Model N-gram s n=2 se dívá pouze na slovo těsně před ním. Pokud jste napsali "New", uhodl by "York", protože "New York" se vyskytuje často. Pokud jste napsali "The", mohl by hádat "cat". Měly nulovou paměť na větu předtím. Pokud byste napsali: "The man who lived in the white house on the hill called New...", jednoduchý N-gram model by pravděpodobně stále hádal "York". Uniká mu kontext, že možná mluvíte o místě.

Doba bronzová: Rekurentní neuronové sítě (RNN). RNN a LSTM byly špičkou před rokem 2017. Pokoušely se "pamatovat" si historii smyčkováním informací zpět. Zpracovávaly text sekvenčně, jako když člověk čte větu slovo od slova.

Úzké hrdlo: Protože četly sekvenčně, trpěly problémem mizejícího gradientu. Než se model dostal na konec dlouhého odstavce, signál ze začátku vybledl. Matematický gradient používaný k aktualizaci vah se stal tak malým, že fakticky zmizel. Nemohly spojit zájmeno v poslední větě s podstatným jménem v první. Jejich výpočet byl také pomalý, protože práci nebylo možné paralelizovat. Museli jste počkat na zpracování slova č. 1, než mohlo začít slovo č. 2.

Průmyslová revoluce: Transformer. V roce 2017 výzkumníci Google publikovali "Attention Is All You Need". To představilo Transformer. Tohle změnilo všechno. Transformery zcela opustily rekurenci. Místo zpracování 100 slov jedno po druhém zpracovává Transformer všech 100 slov najednou (paralelně). To umožnilo dvě věci: masivní škálovatelnost na GPU a schopnost spojit jakékoli slovo s jakýmkoli jiným slovem bez ohledu na vzdálenost.

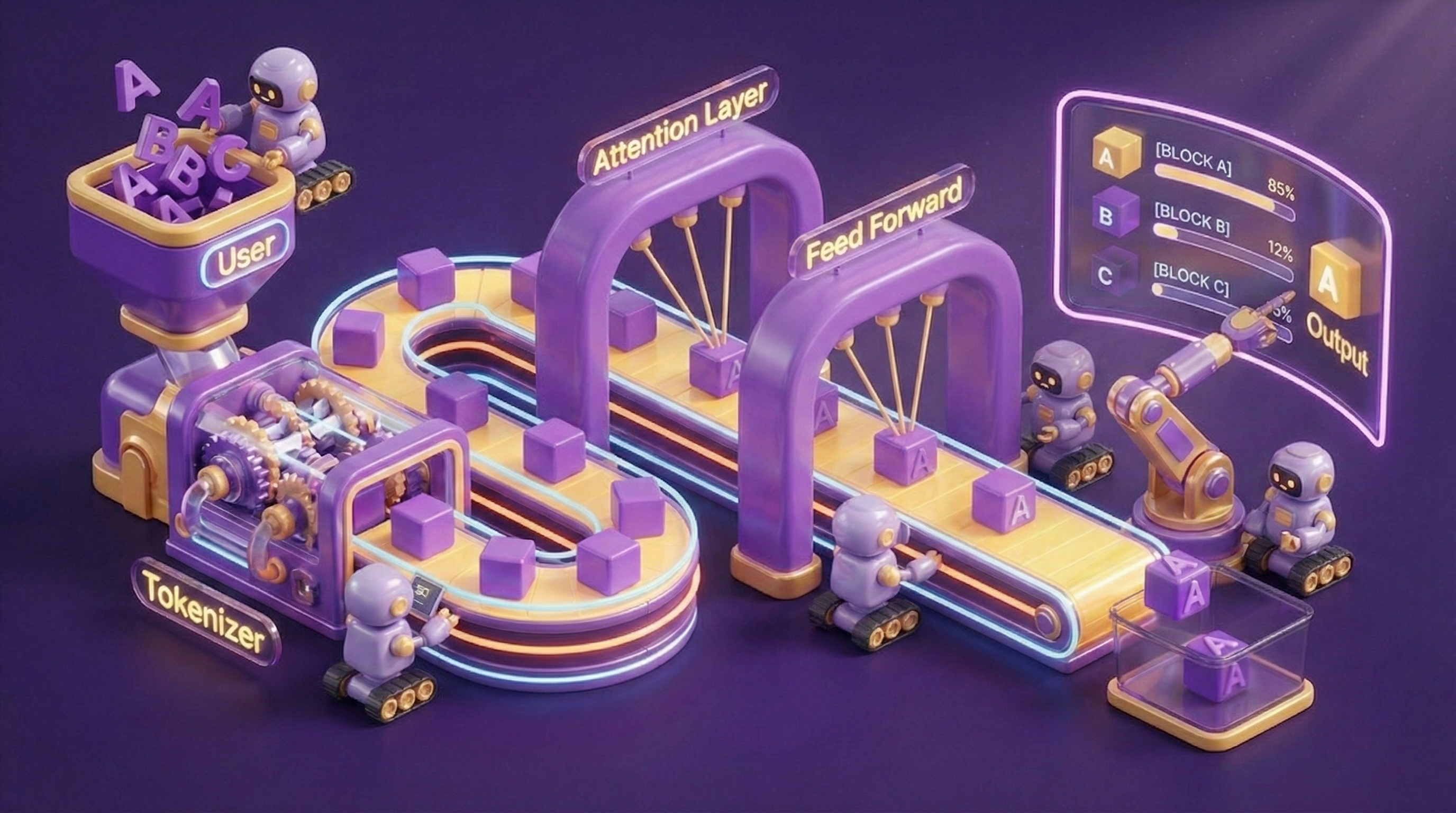

Architektura: Vše je o Transformeru

Srdcem Transformeru je mechanismus zvaný Samo-pozornost (Self-Attention). Díky tomu model chápe kontext. Představte si čtení věty. Jednoduchý model přečte "bank" (břeh/banka) a napadne ho "money" (peníze). Transformer čte celou větu: "The bank of the river" (Břeh řeky). Vypočítá "skóre pozornosti" mezi "bank" a každým dalším slovem. Vidí, že "river" (řeka) je v tomto kontextu pro "bank" vysoce relevantní, zatímco "money" nikoliv.

Mechanismus: Query, Key a Value. Jak to dělá matematicky? Rozdělí každé slovo do tří vektorů:

1. Query (Q): Co hledám? (např. "Jsem přídavné jméno a hledám podstatné jméno, které bych upravilo.")

2. Key (K): Co obsahuji? (např. "Jsem podstatné jméno.")

3. Value (V): Jakou informaci předávám dál? (např. "Jsem koncept 'modré'.")

Model provede skalární součin Query jednoho slova proti klíčům (Keys) všech ostatních slov. Pokud se shodují, skóre pozornosti je vysoké. Poté načte hodnotu (Value). To se děje napříč Vícehlavou pozorností (Multi-Head Attention), což znamená, že to model dělá 12, 24 nebo 96krát paralelně. Zaměřuje se na různé aspekty (gramatika, rod, čas, sémantický vztah) současně.

Vrstvy: Hluboké učení v akci

Když říkáme "Hluboké učení" (Deep Learning), mluvíme o hloubce neuronové sítě. Konkrétně o počtu vrstev, které má. Představte si LLM jako obrovský stoh palačinek. Každá palačinka je vrstva zpracování, která řeší určitou úroveň abstrakce. Tomu se říká Extrakce rysů (Feature Extraction).

Poté, co mechanismus samo-pozornosti rozhodne, kam se dívat, data procházejí Dopřednou sítí (FFN) uvnitř vrstvy. Zde model "přemýšlí". Přebírá shromážděný kontext a aplikuje nelineární transformace (pomocí aktivačních funkcí jako GeLU nebo SwiGLU) ke zpracování informací.

Spodní vrstvy zpracovávají základní syntaxi a gramatiku. Rozpoznají, že "Jablko" je podstatné jméno. Řeší lokální vzory.

Střední vrstvy začínají chápat sémantické souvislosti a entity. Spojují "Jablko" s "ovocem", "technologií", "koláčem" a "Stevem Jobsem". Rozlišují význam na základě skóre pozornosti.

Horní vrstvy řeší komplexní uvažování, záměr a abstraktní pojmy. Chápou, že pokud žádáte o "recept na jablečný koláč", potřebujete postup a ingredience, nikoli korporátní historii. Syntetizují rysy nižší úrovně do koherentní predikce.

Moderní LLM mají desítky těchto vrstev (často 80+). Jak jimi informace proudí vzhůru, mění se ze surového vstupu tokenů na sofistikované "porozumění".

Parametry: Váhy a nastavení

Často slyšíte o modelech se "70 miliardami" parametrů. Parametry jsou interní proměnné (váhy a posuny/biases), které model upravuje během tréninku. Představte si neuronovou síť jako masivní ústřednu s miliardami otočných knoflíků.

Váhy (w): Určují sílu spojení mezi dvěma neurony. Pokud je koncept "Král" silně spojen s "Královnou", je tato váha matematicky vysoká.

Posuny/Biases (b): Odsazení, které umožňuje neuronu posunout jeho práh aktivace.

Výstupem neuronu je v podstatě y = f(wx + b). Nyní si představte doslova miliardy těchto rovnic spojených dohromady. Každý parametr je 16bitové nebo 32bitové číslo s plovoucí desetinnou čárkou. Model se 70 miliardami parametrů vyžaduje zhruba 140 GB VRAM (videopaměti) jen k načtení do paměti (při 16bitové přesnosti). Proto běh těchto modelů lokálně vyžaduje výkonný hardware.

Predikční motor: Tokeny a pravděpodobnost

Ve svém absolutním jádru je LLM predikční stroj. Ale nečte slova jako my. Čte Tokeny.

1. Tokenizace: Jazyk čísel. Model nemůže zpracovat surový text. Používá Tokenizér (jako Byte-Pair Encoding) k rozdělení textu na celočíselná ID. Běžná slova jako "jablko" jsou jednotlivé tokeny. Složitá slova mohou být rozdělena. Model vidí proud čísel: [105, 9923, 552]. Jde o kompresní metodu. Optimalizuje slovní zásobu (obvykle 32k až 100k tokenů), aby co nejefektivněji pokryla jazyk.

2. Poslední vrstva: Logits a Softmax. Po průchodu všemi vrstvami model vypustí vektor "Logitů". To jsou surová skóre pro každý token v jeho slovní zásobě. K přeměně těchto skóre na pravděpodobnosti používá funkci Softmax. Ta skóre stlačí tak, aby jejich součet dával 100 %. "Paříž" (99,1 %), "Londýn" (0,8 %).

3. Vzorkování: Teplota a Top-P. Jak vybere další slovo? Vzorkuje z tohoto rozdělení pravděpodobnosti. Teplota (Temperature) řídí "plochost" rozdělení. Nízká teplota (0,1) zostřuje vrchol a nutí model téměř vždy vybrat nejlepší volbu (Deterministické). Vysoká teplota (1,0) jej zplošťuje a dává šanci i méně pravděpodobným slovům (Kreativní).

LLM vs. Tradiční kód

| Vlastnost | Tradiční software | Velký jazykový model |

|---|---|---|

| Logika | Deterministická (Pokud X, tak Y) - Explicitní | Pravděpodobnostní (Při X je pravděpodobné Y) - Implicitní |

| Aktualizace | Přepsat kód, zkompilovat | Přetrénovat nebo doladit (fine-tune) váhy |

| Chyby | Bugy / Pády aplikace | Halucinace |

Problém "Černé skříňky" a halucinace

Proč LLM lžou? Říkáme tomu Halucinace. Protože je model pravděpodobnostní, upřednostňuje shodu se vzorem před pravdou. Dokončuje vzor věty, místo aby vyhledával fakt z databáze. Pokud je statisticky nejpravděpodobnějším pokračováním věty výmysl (protože zní věrohodně, plynule a odpovídá tónu), model ho bez váhání vygeneruje. Nemá žádný koncept "pravdy". Pouze "pravděpodobnosti".

Mechanistická interpretovatelnost. Tyto modely jsou navíc Černé skříňky. Známe architekturu (Transformery) a učící algoritmus (Zpětná propagace/Backpropagation), ale nerozumíme vnitřní reprezentaci. Ani inženýři, kteří staví GPT-4, nemohou ukázat na konkrétní neuron a říct: "Tady ví, jaké je hlavní město Francie." Výzkumníci nyní používají Lineární sondy a Řídké autoenkodéry, aby se pokusili tyto vnitřní stavy zmapovat. Zjišťují, že modely si vytvářejí "rysy" pro koncepty jako "čestnost", "kódování" nebo dokonce "klamání". Ale mapa je stále z velké části prázdná.

Trénink: Čtení knihovny

Jak se model učí? Tréninkový proces je masivní, drahý a vícestupňový.

1. Předtrénink (Základní model). Model čte masivní korpus textu (Internet, Knihy). Cíl je jednoduchý: Predikce dalšího tokenu. Hraje hru na "doplňování mezer" bilionkrát. Tím, že zakryje další slovo a snaží se ho uhodnout, se učí gramatiku, syntaxi, znalosti o světě a uvažování. Výsledkem je "Základní model" (Base Model). Je chytrý, ale neukázněný.

2. Učení s učitelem (SFT - Supervised Fine-Tuning). Aby byl model užitečným asistentem, provádíme SFT. Ukážeme modelu tisíce příkladů vysoce kvalitních párů "Instrukce -> Odpověď" napsaných lidmi. Model se učí následovat instrukce, místo aby jen automaticky dokončoval text.

3. RLHF (Reinforcement Learning from Human Feedback). Toto je finální krok zarovnání (alignment). Za prvé, model vygeneruje dvě odpovědi. Za druhé, člověk seřadí, která je lepší. Za třetí, vytrénujeme Odměnový model (Reward Model), aby předvídal lidské preference. Nakonec použijeme tento Odměnový model k doladění LLM pomocí PPO (Proximal Policy Optimization). To směruje váhy modelu k žádoucí lidské interakci. Efektivně to "lobotomizuje" škodlivé chování a zvyšuje užitečnost.

Závěr

Velké jazykové modely představují zásadní posun v informatice. Přešli jsme od "říkání počítači, co má dělat" (programování) k "učení počítače, jak myslet" (trénink). Jsou to sofistikované statistické motory. Ne magie. Jsou výsledkem masivního výpočetního výkonu, chytrého inženýrství a součtu lidských znalostí spojených ve vícerozměrném vektorovém prostoru.

V Chatbot.expert využíváme tuto komplexní technologii k budování jednoduchých a výkonných řešení pro vaše podnikání. Překlenujeme propast mezi surovou silou LLM a spolehlivostí, kterou vaše firma potřebuje. Navigujeme v pravděpodobnostech, abychom dodali deterministickou hodnotu.